Što je Apache Hadoop ekosustav?

Apache Hadoop Ekosustav je okvir ili platforma podataka otvorenog koda koja je dodijeljena za spremanje i ispitivanje ogromne zbirke podataka nestrukturirane. Širom svijeta danas se prenosi mnoštvo podataka s brojnih digitalnih platformi s vodećom inovativnom tehnologijom velikih podataka. Štoviše, Apache Hadoop je prvi koji je stekao ovaj tok inovacija.

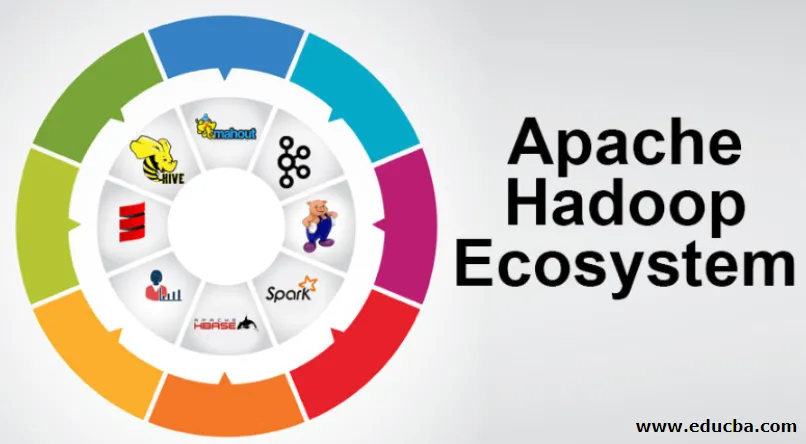

Što se sastoji od Hadoop Data arhitekture / ekosustava?

Hadoop ekosustav nije programski jezik ili usluga, to je okvir ili platforma koja brine o velikim podacima. Možete ga prepoznati kao paket koji obuhvata različite usluge kao što su pohranjivanje, gutanje, održavanje i analiza unutar njega. Zatim ispitajte i sažeto razmišljajte o tome kako službe djeluju isključivo i u suradnji. Apache Hadoop arhitektura se sastoji od različitih inovacija i Hadoop elemenata pomoću kojih se čak i komplicirana informacijska pitanja mogu učinkovito riješiti.

Slijedi prikaz svakog dijela: -

1) Namenode: vodi proces informiranja

2) Datanode: Sastavlja podatke u lokalnu pohranu. Spremanje svih podataka na jedinstvenom mjestu ne preporučuje se kontinuirano, jer može prouzrokovati gubitak podataka u slučaju prekida rada.

3) Tragač zadatka: primaju dužnosti dodijeljene podređenom čvoru

4) Karta: uzima informacije iz potoka i svaki se redak obrađuje podijeljen kako bi se dijelio u različita polja

5) Smanjenje: Ovdje se polja, pribavljena putem Mape, skupljaju ili povezuju jedno s drugim

Ekosistem Apache Hadoop - korak po korak

Svaki element Hadoop ekosustava, kao specifični aspekti, je očigledan. Opsežna perspektiva strukture Hadoop nudi značajnu kvalitetu distribuiranim datotečnim sustavima (HDFS), Hadoop YARN, Hadoop MapReduce i Hadoop MapReduce iz ekosustava Hadoopa. Hadoop čak daje svakoj Java biblioteci, značajne zapise na Java-u, odraz razine OS, prednosti i skripte za rad s Hadoop-om, Hadoop YARN je metoda za izradu poslovnih ideja i upravljanje resursima. U konfiguraciji Hadoop, HDFS daje visoku propusnost prolaza informacijama o aplikacijama, a Hadoop MapReduce daje paralelnu pripremu opsežnog asortimana podataka temeljenog na YARN.

Pregled ekosustava Apache Hadoop

To je osnovni predmet koji trebate shvatiti prije nego što započnete rad s Hadoop ekosustavom. Ispod su bitne komponente:

- HDFS: Ovo je središnji dio Hadoop ekosustava i on može uštedjeti ogromnu količinu nestrukturiranih, strukturiranih i polustrukturiranih informacija.

- PRIJET: To podseća na um ekosustava Hadoop i sve rukovanje se provodi izravno ovdje, što može uključivati raspodjelu imovine, zakazivanje rasporeda i pripremu akcija.

- MapReduce: Spoj je dva procesa, opisanih kao Map and Reduce i sastoji se u osnovi pripreme dijelova koji sastavljaju ogromne zbirke informacija koristeći paralelne i raspršene algoritme unutar ekosustava Hadoop.

- Apache Pig: To je jezik postupka, koji se koristi za paralelno rukovanje aplikacijama za obradu ogromnih zbirki informacija u stanju Hadoop, a ovaj je jezik opcija za Java programiranje.

- HBase: To je open-source i ne pridružena baza podataka ili NoSQL. Time se poboljšavaju sve vrste informacija kako bi se mogle nositi s bilo kojom vrstom informacija unutar Hadoop okvira.

- Mahout, Spark MLib: Mahout se koristi za strojno učenje i daje prirodi za stvaranje aplikacija za strojno učenje.

- Zookeeper: Za rješavanje grupa može se koristiti Zookeeper, inače se naziva gospodar koordinacije, što može dati pouzdanu, brzu i razvrstanu operativnu upravu za Hadoop grozdove.

- Oozie: Apache Oozie upravlja s rasporedom rada i djeluje kao usluga uzbunjivanja i takta unutar Hadoop ekosustava.

- Ambari: Riječ je o programu Apache Software Foundation i ekološki sustav Hadoop može izvoditi progresivno fleksibilno.

Hadoop PRIJA:

Razmislite o JARNU kao o umu vašeg Hadoop ekosustava. Ono prikazuje cjelokupnost postupaka obrade dodjeljivanjem imovine i planiranjem.

Ima dva značajna segmenta koji su ResourceManager i NodeManager.

- ResourceManager: - To je opet glavni čvor u operativnom odjeljenju. Dobivaju pripremne upite i nakon toga dijele upite koji se odnose na NodeManagers, gdje se događa pravo rukovanje.

- NodeManageri: - Oni se instaliraju na svaki DataNode. Zadužen je za izvršavanje zadatka na svakoj DataNode.

Kako djeluje apache Hadoop?

- Namjera je uspona s pojedinačnih poslužitelja na ogromnu količinu strojeva, od kojih svaki pruža lokalne račune i kapacitet. Umjesto da ovisi o opremi za prenošenje velike pristupačnosti, sama knjižnica namijenjena je razlikovanju i rješavanju razočaranja na aplikacijskom sloju, tako da pruža izuzetno dostupnu uslugu preko hrpe računala, od kojih bi svako moglo biti sklono razočaranjima.

- No, potražite dalje, a na poslu se značajno povećava šarm. Hadoop je potpuno modularan, što znači da možete zamijeniti praktički bilo koji od njegovih segmenata alternativnim softverskim alatom. To arhitekturu čini fantastično prilagodljivom, jednako snažnom i učinkovitom.

Apache Hadoop Spark:

- Apache Spark je sustav za analizu informacija u stvarnom vremenu u raspršenim računalnim postavkama. Ona provodi izračune u memoriji kako bi izgradila brzinu upravljanja informacijama.

- Brže je za rukovanje opsežnim informacijama jer koristi izračune u memoriji i različita poboljšanja. Uzduž tih linija, potrebna je velika sila obrade.

Kako djeluje Apache Pig?

- Apache Pig je koristan sustav Yahoo razvijen je za učinkovito i glatko ispitivanje ogromnih pozicija informacija. Daje neki vrhunski jezik svinjskog jezika svinjski jezik koji je poboljšan, proširiv i jednostavan za upotrebu.

- Izuzetna komponenta svinjskih programa u kojoj je njihov sastav dostupan značajnoj paralelizaciji što pojednostavljuje brigu o značajnim zbirkama informacija.

Slučaj upotrebe svinja:

- Podaci o privatnoj zdravstvenoj zaštiti pojedinca privatni su i ne bi ih trebali objavljivati drugim ljudima. Te bi podatke trebalo prikriti radi očuvanja tajnosti, ali podaci o medicinskim uslugama ogromni su do te mjere da je prepoznavanje i isključenje pojedinačnih zdravstvenih podataka neophodno. Spapa Apache može se koristiti u takvim uvjetima za prepoznavanje zdravstvenih podataka.

Zaključak:

- Nacrtano je da se s jednog servera uspinje do ogromne količine strojeva, koji pružaju sve mogućnosti i račune u blizini. No, potražite dalje, a na poslu je sve više očaravanja.

- Hadoop je potpuno modularan, što znači da možete zamjenjivati praktički bilo koji od njegovih dijelova alternativnim softverskim alatom. To strukturu čini fantastično prilagodljivom, jednako snažnom i učinkovitom.

Preporučeni članci

Ovo je vodič za Ekosistem Apache Hadoop. Ovdje smo razgovarali o tome što je Apache Hadoop ekosustav? pregled Hadoop arhitekture i funkcioniranje Hadoop ekosustava. Možete i proći naše druge predložene članke da biste saznali više -

- Komponente ekosustava Hadoop

- Kako instalirati Apache

- Trening iskre za Apache

- Karijera u Hadoopu