Uvod u klasifikacijske algoritme

Ovaj članak o klasifikacijskim algoritmima daje pregled različitih načina klasifikacije koji se obično koriste u tehnikama vađenja podataka s različitim principima. Razvrstavanje je tehnika koja kategorizira podatke u različiti broj klasa i zauzvrat se svakoj klasi daju oznake. Glavni cilj klasifikacije je identificirati klasu za pokretanje novih podataka analizom skupa obuke, uvidom u ispravne granice. Općenito, predviđanje ciljne klase i gore spomenuti postupak naziva se klasifikacija.

Na primjer, rukovodstvo bolnice bilježi ime pacijenta, adresu, starost, prethodnu povijest pacijentovog zdravlja da bi ih se postavilo na dijagnozu, što pomaže klasificiranju pacijenata. Mogu se razlikovati u dvije faze: faza učenja i faza ocjenjivanja. Modeli faza učenja baza pristupa ne daje podatke o treningu, dok faza evaluacije predviđa izlaz za dane podatke. Njihove aplikacije mogli bismo pronaći u neželjenoj pošti putem e-pošte, predviđanju bankarskih zajmova, prepoznavanju govora, analizi osjećaja. Tehnika uključuje matematičku funkciju f s ulazom X i izlazom Y.

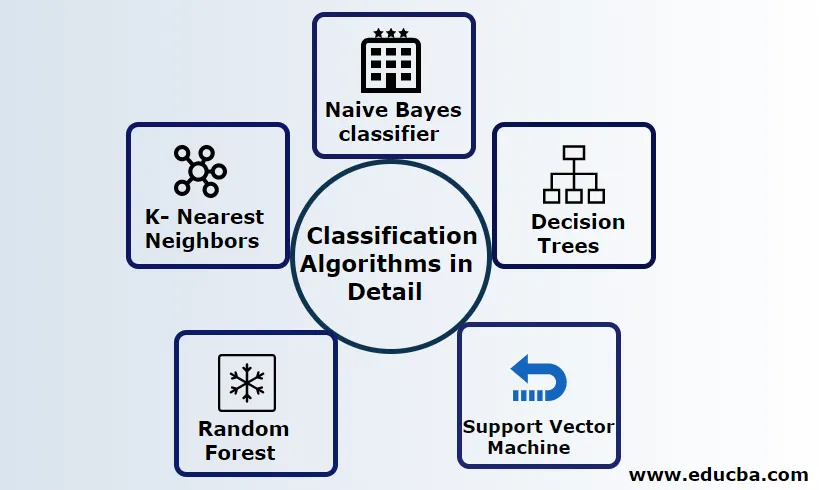

Objasnite algoritme klasifikacije detaljno

Klasifikacija se može izvesti i na strukturiranim i na nestrukturiranim podacima. Razvrstavanje se može kategorizirati u

- Naivni Bayesov klasifikator

- Stabla odluka

- Podrška vektorski stroj

- Slučajna šuma

- K- najbliži susjedi

1) Naivni Bayesov klasifikator

To je Bayesov algoritam temeljen na teoremu, jedna od statističkih klasifikacija i zahtijeva malo količine podataka o obuci da bi se procijenili parametri također poznati kao vjerojatni klasifikatori. Smatra se najbržim klasifikatorom, visoko skalabilnim i rukuje diskretnim i kontinuiranim podacima. Ovaj se algoritam koristio za predviđanje u stvarnom vremenu. Postoje različite vrste naivnog klasifikatora, Multinomial Naive Bayes, Bernoulli Naive Bayes, Gaussian naive.

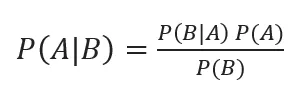

Bayesovu klasifikaciju s posteriornim vjerojatnostima dajemo sa

Gdje su A, B događaji, P (A | B) - posteriorne vjerojatnosti.

Ako su dvije vrijednosti međusobno neovisne,

P (A, B) = P (A) P (B)

Naivni Bayes može se graditi pomoću python biblioteke. Naiveovi prediktori su neovisni, iako se koriste u sustavima preporuka. Koriste se u mnogim aplikacijama u stvarnom vremenu i dobro se koriste u razvrstavanju dokumenata.

prednosti:

Prednosti su u tome što zahtijevaju vrlo manje računske snage, pretpostavljaju se u problemima predviđanja više klasa, točno rade na velikim skupovima podataka.

Hendikep:

Glavni nedostatak ovog klasifikatora je da će dodijeliti nultu vjerojatnost. A imaju svojstva s kojima su međusobno neovisni.

2) Stablo odluke

To je model pristupa odozgo prema dolje s strukturom dijagrama toka obrađuje podatke visoke dimenzije. Rezultati se predviđaju na temelju zadane ulazne varijable. Stablo odluke sastavljeno od sljedećih elemenata: korijen, mnogo čvorova, grana, lišća. Korijenski čvor čini particiju na temelju vrijednosti atributa klase, unutarnji čvor uzima atribut za daljnju klasifikaciju, grane donose pravilo odlučivanja o dijeljenju čvorova na listove čvorova, na kraju, listovi čvorovi daju nam konačni ishod. Vremenska složenost stabla odlučuje ovisno o broju zapisa, atributa podataka o treningu. Ako je stablo odluke predugo, teško je dobiti željene rezultate.

Prednost: Primjenjuju se za prediktivnu analizu za rješavanje problema i svakodnevno se koriste u svakodnevnim aktivnostima za odabir cilja na temelju analize odluka. Automatski izrađuje model na temelju izvornih podataka. Najbolje u obradi nedostajućih vrijednosti.

Nedostatak: Veličina stabla je nekontrolirano sve dok nema nekih kriterija zaustavljanja. Stablo je zbog hijerarhijske strukture nestabilno.

3) Podrška vektorski stroj

Ovaj algoritam igra vitalnu ulogu u problemima s klasifikacijom i najčešće je to algoritam strojnog učenja pod nadzorom. To je važno sredstvo koje koristi istraživač i istraživač podataka. Ovaj SVM je vrlo jednostavan i njegov je postupak pronalaženje hiperplana u točki podataka N-dimenzionalnih podataka. Hiperplane su granice odluka koje klasificiraju podatkovne točke. Sav taj vektor pada bliže hiperplani, maksimizirajući maržu klasifikatora. Ako je marža maksimalna, najmanja je pogreška generalizacije. Njihova se implementacija može obaviti s kernelom koristeći python s nekim skupovima podataka o treningu. Glavni je cilj SVM-a obučiti objekt u određenoj klasifikaciji. SVM nije ograničen na linearni klasifikator. SVM je preferiran više od bilo kojeg klasifikacijskog modela zbog svoje funkcije kernela koja poboljšava računalnu učinkovitost.

Prednost: Oni su vrlo poželjni zbog manje računske snage i učinkovite točnosti. Učinkovit u prostoru s velikim dimenzijama, dobra učinkovitost memorije.

Nedostatak: Ograničenja u brzini, jezgri i veličini

4) Slučajna šuma

To je moćan algoritam strojnog učenja temeljen na pristupu Ensemble učenja. Osnovni građevni blok Random šume je stablo odluka koje se koristi za izgradnju prediktivnih modela. Demonstracija rada uključuje stvaranje šume stabala s slučajnim odlukama, a postupak obrezivanja obavlja se postavljanjem zaustavnih dijelova kako bi se postigao bolji rezultat. Slučajna šuma provodi se tehnikom koja se naziva vreća za donošenje odluka. To pakiranje sprječava prekomjerno uklapanje podataka smanjenjem pristranosti slično kao što ovaj slučajni slučaj može postići bolju točnost. Konačno predviđanje uzima prosjek mnogih stabala odluka tj. Česta predviđanja. Nasumična šuma uključuje mnoge slučajeve upotrebe poput predviđanja burze, otkrivanja prijevara, vijesti.

prednosti:

- Ne zahtijeva velika obrada za obradu skupova podataka i vrlo jednostavan model za izgradnju. Pruža veću točnost pomaže u rješavanju problema predviđanja.

- Uspješno postupa s nedostajućim vrijednostima i automatski otkriva vanjski oblik.

Hendikep:

- Zahtijeva visoke računske troškove i veliku memoriju.

- Zahtijeva mnogo više vremenskog razdoblja.

5) K- najbliži susjedi

Ovdje ćemo raspravljati o K-NN algoritmu uz nadzirano učenje za CART. Koriste K pozitivni mali cijeli broj; objekt se dodjeljuje klasi na temelju susjeda ili ćemo reći dodjeljivanje grupi promatranjem u kojoj skupini leži susjed. To se bira mjerenjem udaljenosti od Euklidove udaljenosti i udarnom silom. Vrijednost K može se pronaći korištenjem postupka podešavanja. KNN ne želi naučiti nijedan model za obuku novog skupa podataka i korištenje normalizacije za ponovno skaliranje podataka.

Prednost: daje učinkovite rezultate ako su podaci o treningu ogromni.

Nedostatak: Najveći problem je što ako je varijabla mala, dobro funkcionira. Drugo, odabir K faktora uz klasifikaciju.

Zaključak

Zaključno, prošli smo mogućnosti različitih algoritama za klasifikaciju i dalje djeluje kao moćan alat u inženjerstvu značajki, klasifikacija slika koja igra sjajan resurs za strojno učenje. Algoritmi za klasifikaciju su snažni algoritmi koji rješavaju teške probleme.

Preporučeni članci

Ovo je vodič za klasifikacijske algoritme u strojnom učenju. Ovdje razmatramo da se Klasifikacija može izvesti i na strukturiranim i na nestrukturiranim podacima. Možete i pregledati naše druge predložene članke -

- Algoritmi usmjeravanja

- Algoritam klastera

- Proces rudarjenja podataka

- Algoritmi strojnog učenja

- Najčešće korištene tehnike ansamblovskog učenja

- C ++ algoritam | Primjeri C ++ algoritma