Razlika između Hadoopa i SQL-a

Ogromni podaci generirani svake sekunde putem društvenih medija poput Facebooka, Twittera i Instagrama, otvorili su put razvoju Hadoop / Big Data Ekosustava. Izraz "3V" koji se odnosi na volumen, brzinu i istinitost definira važnost Hadoopa za rukovanje streaming podacima. Danas se podaci generiraju iz više izvora koje je potrebno integrirati u različite svrhe poput izvješćivanja, analize podataka i istraživanja te za centralizirano pohranjivanje podataka. Kad to radimo, pojavljuju se brojna pitanja s tradicionalnim pristupima poput prostora, pristupa, integriteta, strukture i širine pojasa. Da bi se nosio sa svim tim problemima, Hadoop pruža okvir koji omogućava obradbu podataka ogromnih veličina, lagan pristup, veliku dostupnost i dinamičko učitavanje podataka. Ima okvir distribuiranog datotečnog sustava (HDFS) za pohranu podataka i ugrađeni procesor upita koji se naziva „Smanjivanje mape“ za analizu i obradu podataka pohranjenih u HDFS.

Usporedba između glave Hadoop Vs SQL

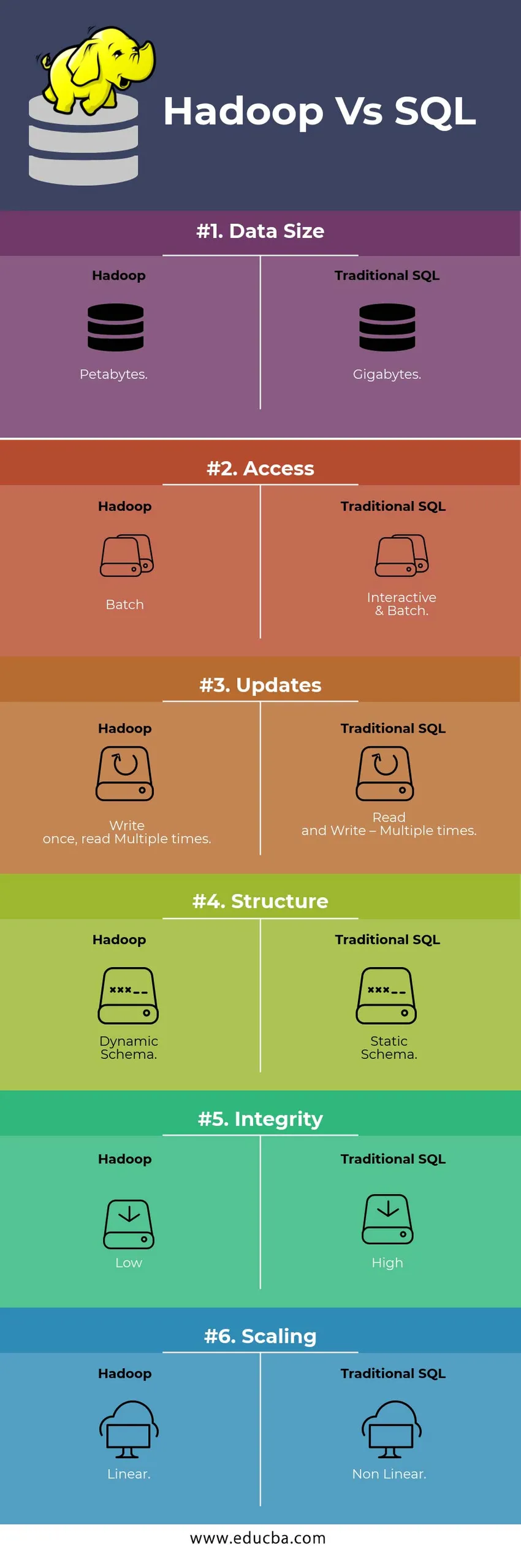

Ispod je top 6 razlike između Hadoop Vs SQL

Ključne razlike između Hadoop Vs SQL

Ispod je razlika između Hadoopa i SQL-a

- Shema na WRITE VS PROČITAJTE

Obično u tradicionalnoj bazi podataka tijekom učitavanja / migracije podataka iz jedne u drugu bazu slijedi shemu pristupa pisanju. Zbog toga se proces učitavanja podataka uzbuđuje / prekida i dolazi do odbijanja zapisa zbog razlike u strukturi izvornih i ciljnih tablica, dok su u sustavu Hadoop svi podaci pohranjeni u HDFS, a podaci su centralizirani.

Hadoop okvir uglavnom se koristi za proces analize podataka. Stoga podržava sve tri kategorije podataka, tj. Strukturirane, polustrukturirane i nestrukturirane podatke i omogućuje shemu pristupa čitanju.

- Strukturirani podaci imaju određeni format. g .: XML datoteka.

- Podaci Semi Strukture su gubitnički; Možda nema / nema shemu. g.: proračunska tablica

- Nestrukturirani podaci nemaju određenu strukturu ili shemu. Npr .: običan tekst ili slika.

Hadoop učinkovito radi s nestrukturiranim podacima jer ima mogućnost interpretacije podataka tijekom vremena obrade.

| Pristup | Prednost | Hendikep |

| Shema on Write | · Unaprijed definirane strukture

· Brže čitanje. Npr .: tradicionalni RDBMS. | Sporo učitavanje podataka

Visoka kašnjenja |

| Shema on Read | · Dinamička struktura

· Brzo pisanje i čitanje. Npr .: Hadoop | Brzo učitavanje podataka

Niska latencija |

Tablica : Shema na WRITE VS shemi READ.

- SCALABILNOST I TROŠKOVI

Hadoop Framework dizajniran je za obradu velike količine podataka. Kad god se povećava veličina podataka, niz dodatnih resursa poput čvora podataka može se dodati klasteru vrlo lako od tradicionalnog pristupa raspodjeli statičke memorije. Vrijeme i proračun su relativno vrlo manji za njihovu implementaciju, a Hadoop pruža Locality podataka gdje su podaci dostupni na čvoru koji je izvršio zadatak.

- TOLERANCIJA KVAROVA

U tradicionalnom RDBMS-u, kada se podaci izgube zbog korupcije ili bilo kakvog mrežnog problema, potrebno je više vremena, troškova i resursa da biste vratili izgubljene podatke. No, Hadoop ima mehanizam u kojem podaci imaju najmanje tri razine faktora replikacije za podatke koji su pohranjeni u HDFS. Ako jedan od čvorova podataka koji sadrže podatke ne uspije, podaci se mogu lako izvući iz drugih čvorova podataka s velikom dostupnošću podataka. Stoga podaci lako postaju dostupni korisniku bez obzira na kvar.

- FUNKCIONALNO PROGRAMIRANJE

Hadoop podržava pisanje funkcionalnog programa na jezicima kao što su java, skala i python. Za svaku aplikaciju koja zahtijeva bilo kakvu dodatnu funkcionalnost može se implementirati registracijom UDF - korisnički definirane funkcije u HDFS. U RDBMS-u ne postoji mogućnost pisanja UDF-a i to povećava složenost pisanja SQL-a. Nadalje, podacima pohranjenim u HDFS-u može pristupiti sav Hadoop ekosustav poput košnica, svinja, sqoopa i HBase. Ako je zapisan UDF, može ga koristiti bilo koja od gore spomenutih aplikacija. Povećava performanse i podržavanje sustava.

- OPTIMIZACIJA

Hadoop pohranjuje podatke u HDFS i obrađuje, iako je smanjenje karte smanjeno velikim tehnikama optimizacije. Najpopularnije tehnike koje se koriste za rukovanje podacima koriste particioniranje i spajanje spremljenih podataka. Particija je pristup za spremanje podataka u HDFS dijeljenjem podataka na temelju stupca koji je spomenut za particiju. Kad se podaci ubrizgaju ili učitaju u HDFS, on identificira particijski stupac i gura ih u dotični direktorijski particiju. Dakle, upit dobiva skup rezultata izravno dohvaćanjem podataka iz particionirane mape. Ovo smanjuje skeniranje cijele tablice, poboljšava vrijeme odziva i izbjegava kašnjenje.

Drugi pristup se naziva Skupljanje podataka. To omogućuje analitičaru da lako distribuira podatke između čvorova podataka. Svi će čvorovi distribuirati jednak broj podataka. Stupac za skupljanje izabran je na način da ima najmanji broj kardinalnosti.

Ti pristupi nisu dostupni u tradicionalnoj metodi SQL-a.

- VRSTA PODATAKA

U tradicionalnom pristupu, podržani tipovi podataka vrlo su ograničeni. Podržava samo strukturirane podatke. Stoga će za čišćenje i formatiranje samih shema podataka biti potrebno više vremena. No, Hadoop podržava složene vrste podataka poput Array, Struct i Map. To potiče korištenje različitih vrsta skupa podataka koji će se koristiti za učitavanje podataka. Za primjer: XML podaci mogu se učitati definiranjem podataka s XML elementima koji sadrže složeni tip podataka.

- SASTAV PODATAKA

Na raspolaganju je vrlo manje ugrađenih tehnika kompresije za tradicionalni sustav baze podataka. Ali za Hadoop okvir postoje mnoge tehnike kompresije poput gzib, bzip2, LZO i snappy. Zadani način kompresije je LZ4. Čak se i tablice mogu komprimirati pomoću tehnika kompresije poput parketa, ORC-a. Tehnike kompresije pomažu u tome da tablice zauzimaju vrlo manje prostora povećavaju propusnost i brže izvršavanje upita.

Tablica usporedbe Hadoop Vs SQL-a

| Karakteristike | Tradicionalni SQL | Hadoop |

| Veličina podataka | gigabajta | petabajta |

| Pristup | Interaktivna i serija | serija |

| nadopune | Čitanje i pisanje - više puta | Pišite jednom, pročitajte više puta |

| Struktura | Statička shema | Dinamička shema |

| Integritet | visok | nizak |

| skaliranje | Nelinearni | linearan |

Tablica : Usporedba tradicionalnog Hadoopa i SQL okvira.

Zaključak - Hadoop Vs SQL

Sveukupno, Hadoop je korak ispred tradicionalnog SQL-a u pogledu troškova, vremena, performansi, pouzdanosti, mogućnosti podržavanja i dostupnosti podataka vrlo velikoj korisničkoj grupi. Kako bi se učinkovito moglo nositi s ogromnom količinom podataka generiranih svakog dana, Hadoop okvir pomaže u pravodobnom snimanju, pohranjivanju, obradi, filtriranju i konačno pohranjivanju u njega na centraliziranom mjestu.

Preporučeni članak

- Hadoop vs košnica - saznajte najbolje razlike

- Naučite 10 korisnih razlika između Hadoopa i Redshifta

- HADOOP vs RDBMS | Znajte 12 korisnih razlika

- Apache Hadoop vs Apache Spark | Top 10 usporedbi koje morate znati!

- Hadoop vs Spark: Značajke