Uvod u Hadoop okvir

Prije nego što duboko uđemo u tehnički okvir Hadoopa, počet ćemo s jednostavnim primjerom.

Postoji poljoprivredno gospodarstvo koje bere rajčicu i sprema ih u jedno skladište, sada s povećanom potražnjom povrća, farma je počela beriti krumpir, mrkvu - s povećanom potražnjom, nedostajalo je poljoprivrednika pa su zaposlili više poljoprivrednika. Nakon nekog vremena shvatili su da postoji nedostatak u skladištu - pa su povrće distribuirali u različita skladišna područja. Kada je riječ o dohvaćanju podataka, svi rade paralelno s vlastitim prostorom za pohranu.

Pa kako je ova priča povezana s velikim podacima?

Ranije smo imali ograničene podatke, s ograničenim procesorom i jednom jedinicom za pohranu podataka. Ali tada se generiranje podataka povećalo što je dovelo do velike količine i različitih raznolikosti - strukturirane, polustrukturirane i nestrukturirane. Dakle, rješenje je bilo korištenje distribuirane pohrane za svaki procesor, što je omogućilo lak pristup pohrani i pristupu podacima.

Tako sada možemo zamijeniti povrće kao različite vrste podataka i mjesto za pohranu kao distribuirana mjesta za pohranu podataka i različiti radnici koji su svaki procesor.

Dakle, Veliki podaci su izazov i Hadoop igra ulogu Rješenja.

Hadoop

1. Rješenje za VELIKE PODATKE: jer se bavi složenošću velike količine podataka, brzine i raznolikosti podataka.

2. Skup projekta otvorenog koda.

3. Pohranjuje ogromnu količinu podataka pouzdano i omogućuje ogromne distribuirane proračune.

4. Ključni atributi Hadoopa su redundantnost i pouzdanost (apsolutno nema gubitka podataka).

5. Prvenstveno se fokusira na serijsku obradu.

6. Radi se o robnom hardveru - ne morate kupiti neki poseban skuplji hardver.

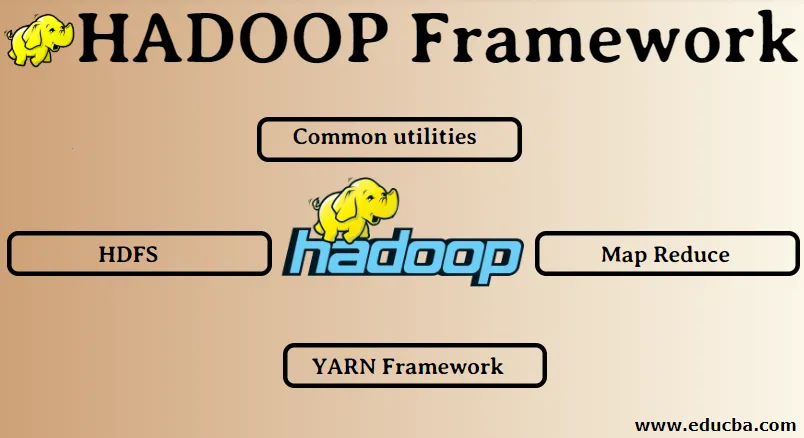

Hadoop okvir:

1. Uobičajeni alati

2. HDFS

3. Smanjivanje karte

4. Okvir pređa

1. Uobičajeni alati:

Također se naziva Hadoop čest. To su samo JAVA biblioteke, datoteke, skripte i uslužni programi koji su za obavljanje ostalih komponenti Hadoop zapravo potrebni ostalim komponentama.

2. HDFS: Distribuirani datotečni sustav Hadoop

Zašto je Hadoop odlučio ugraditi Distribuirani datotečni sustav?

Shvatimo to na primjeru: trebamo pročitati 1TB podataka i nama je jedan stroj s 4 I / O kanala svaki kanal ima 100MB / s, a za čitanje cijelih podataka bilo je potrebno 45 minuta. Sada istu količinu podataka čita 10 strojeva, svaki s 4 I / O kanala, pri čemu svaki kanal ima 100MB / s. Pogodite koliko je vremena trebalo da se pročitaju podaci? 4, 3 minute. HDFS rješava problem pohrane velikih podataka. Dvije glavne komponente HDFS-a su NAME NODE i DATA NODE. Ime čvora je glavni, možda ćemo imati i sekundarni čvor imena u slučaju da primarni čvor imena prestane raditi, sekundarni čvor imena djelovat će kao sigurnosna kopija. Čvor imena u osnovi održava i upravlja čvorovima za podatke spremanjem metapodataka. Čvor podataka je rob koji je u osnovi jeftin roba hardver. Možemo imati više čvorova podataka. Čvor podataka pohranjuje stvarne podatke. Ovaj čvor podataka podržava faktor replikacije, pretpostavimo da ako jedan podatkovni čvor ide dolje, podacima može pristupiti drugi replicirani čvor podataka, dakle, pristupačnost podataka je poboljšana i sprečava se gubitak podataka.

3. Smanjivanje karte:

Rješava problem obrade velikih podataka. Shvatimo kako se koncept karte smanjuje rješavanjem ovog stvarnog problema. ABC tvrtka želi izračunati ukupnu prodaju, po gradu. Sada ovdje koncept hash tablice neće raditi jer su podaci u terabajtima, pa ćemo upotrijebiti koncept Map-Reduce.

Postoje dvije faze: a) MAP. b) SMANJENJE

a) Karta : Prvo ćemo podijeliti podatke u manje dijelove koji se nazivaju preslikači na osnovi para ključ / vrijednost. Dakle, ovdje će ključ biti ime grada, a vrijednost će biti ukupna prodaja. Svaki će kartičar dobiti mjesečne podatke koji daju naziv grada i odgovarajuću prodaju.

b) Smanjite: Dobivat će ove hrpe podataka i svaki reduktor bit će odgovoran za gradove sjever / zapad / istok / jug. Tako će rad reduktora skupljati te male komade i pretvarati ih u veće količine (dodajući ih) za određeni grad.

4.YARN Okvir: Još jedan pregovarač o resursima.

Početna verzija Hadoopa imala je samo dvije komponente: Smanjenje karata i HDFS. Kasnije se shvatilo da smanjenje karte ne može riješiti mnoge velike probleme s podacima. Ideja je bila ukloniti odgovornosti upravljanja resursima i rasporeda poslova od starog motora za smanjenje karata i dodijeliti ga novoj komponenti. Dakle, tako je YARN ušao u sliku. Srednji sloj između HDFS i Map Reduce odgovoran je za upravljanje resursima klastera.

Za obavljanje dvije ključne uloge: a) Zakazivanje poslova. b) Upravljanje resursima

a) Raspored poslova: Kada se velika količina podataka daje na obradu, ona se mora distribuirati i raščlaniti na različite zadatke / poslove. Sada JS odlučuje kojem poslu treba dati glavni prioritet, vremenskom intervalu između dva posla, ovisnosti između poslova, provjerava da ne postoji preklapanje između izvršenih poslova.

b) Upravljanje resursima: za obradu podataka i za pohranu podataka potrebni su nam resursi, zar ne? Tako upravitelj resursa osigurava, upravlja i održava resurse za pohranu i obradu podataka.

Dakle, sada nam je jasno što je s konceptom Hadoop i kako rješava izazove koje su stvorili VELIKI PODACI !!!

Preporučeni članci

Ovo je vodič za Hadoop Framework. Ovdje smo razgovarali i o 4 glavna okvira Hadoopa. Možete i proći naše druge predložene članke da biste saznali više -

- Baza podataka Hadoop

- Ekosistem Hadoop

- Upotrebe Hadoopa

- Poslovi administratora Hadoopa

- Hadoop administrator | Put vještina i karijere